СИНЕРГЕТИКА И ИНФОРМАЦИЯ

Д.С. Чернавский

Слово - "синергетика" в переводе с греческого означает "совместное действие". Предложил этот термин профессор Штудгартского университета Герман Хакен в 1978г. По существу синергетика состоит из математических моделей явлений самоорганизации. Таким образом история повторилась: сама наука появилась раньше чем "слово" ее обозначающее. Тем не менее это "слово" тоже сыграло положительную роль в интеграции наук (как ценная условная информация). В данном случае интеграция произошла на более высоком профессиональном уровне, поскольку человек, не владеющий математикой, синергетиком считаться не может. Сейчас слова "синергетика" и "самоорганизация" часто выступают как синонимы |

Глава 1.

ОСНОВНЫЕ ПОНЯТИЯ ДИНАМИЧЕСКОЙ ТЕОРИИ ИНФОРМАЦИИ

Сейчас имеется несколько (даже много) определений понятия "информация"

и ни одно из них не является общепринятым. Это естественно, поскольку

общепризнанные определения появляются в науке, когда она становится классической

и перестает развиваться. О науке об информации этого, к счастью, сказать

нельзя.

Нужно ли вообще определять это понятие? Вопрос не праздный, поскольку

многие ученые придерживаются мнения о том, что "информация есть информация

и ничто другое и этого достаточно". Действительно, до недавнего времени

слово "информация" использовалось в обыденной жизни и в практических

задачах (шифровка, связь и т.д.). Там было достаточно понимание о чем

идет речь на интуитивном или сугубо прикладном уровне.

В последнее время стало ясно, что информация играет в науке фундаментальную роль. Возникла потребность понять, что же это такое? Попытки связать информацию с привычными понятиями материя или энергия успехом не увенчались. Стало ясно, "информация есть информация, а не материя и не энергия". (Н.Винер [1]). Отрицание не может претендовать на роль определения, вместе с тем в данном случае оно существенно, ибо указывает на отсутствие вещественного (и/или полевого) происхождения информации. Попытки связать информацию с энтропией тоже оказались безуспешными, хотя они продолжаются до сих пор (подробнее мы это вопрос обсудим позже). Поэтому вопрос об определении понятия "информация" остается открытым.

В книге И.В. Мелик-Гайказян [2] собрана коллекция определений слова "информация", которая обсуждалась в [3], ниже мы будем следовать этим работам.

| 1.1 Определения понятия "информация |

- "информация есть знания, переданные кем-то другим или приобретенные путем собственного исследования или изучения" [4];

- "информация - это сведения, содержащиеся в данном сообщении и рассматриваемые как объект передачи, хранения и обработки" [5];

- "информация в обыденном смысле - это сведения, известия, в научно-технических приложениях - то, что имеет на себе сигнал" [6].

Наряду с этими и подобными им определениями заметна тенденция связывать информацию со степенью упорядоченности той системы, которая получает информацию:

- "информация означает порядок, коммуникация есть создание порядка из беспорядка или по крайней мере увеличение степени той упорядоченности, которая существовала до получения сообщения" [7]

Приводимые ниже определения в известной мере повторяются.

- "информация - это обозначение содержания, полученного из внешнего мира в процессе нашего приспособления к нему и приспособления к нему наших чувств" [8];

- "информация...- одно из свойств предметов, явлений, процессов объективной действительности, созданных человеком управляющих машин, заключающееся в способности воспринимать внутреннее состояние и воздействие окружающей среды и сохранять определенное время результаты его; передавать сведения о внутреннем состоянии и накопленные данные другим предметам, явлениям и процессам" [9];

- "информация - объективное содержание связи между взаимодействующими материальными объектами, проявляющееся в изменении состояний этих объектов" [10];

- "информация есть текущие данные о переменных величинах в некоей области деятельности, систематизированные сведения относительно основных причинных связей, которые содержатся в знании как понятии более общего класса, по отношению к которому информация является подчиненной" [4];

- "информация есть знание о каком-то особом событии, случае или о чем-либо подобном" [4];

- "информацией являются все те данные о внешнем мире, которые мы получаем как путем непосредственного воздействия на наши органы чувств окружающих предметов и явлений, так и опосредованным путем через книги, газеты, рассказы других людей" [11];

- "информацией называется всякое сообщение или передача сведений о чем-либо, что заранее не было известно" [12].

Среди философов популярны дефиниции, содержащие термин "отражение":

- "информация в самом общем случае - это разнообразие, которое один объект содержит о другом, это взаимное, относительное разнообразие. С позиций теории отражения информация может быть представлена как отраженное разнообразие, как разнообразие, которое отражающий объект содержит об отраженном" [13];

- "информация есть отражение в сознании людей объективных причинно-следственных связей в окружающем нас реальном мире" [14];

- "информация - это содержание процессов отражения" [15];

- "информация не тождественна отражению, а есть лишь его инвариантная часть, поддающаяся определению, объективированию, передаче" [16].

- "информация - это философская категория, рассматриваемая наряду с такими, как пространство, время, материя. В самом общем виде информацию можно представить как сообщение, т.е. форму связи между источником, передающим сообщение и приемником, его принимающим" [17].

Определения такого типа можно суммировать в виде утверждения:

- "информация есть отражение отображения наших соображений".

Такого определения в литературе нет. По стилю оно соответствует творениям

Кузьмы Пруткова (например, его миниатюре "Спор древне-греческих ученых

о прекрасном"). Тем не менее, по глубине и смыслу (если кто либо

попытается его в нем найти), оно не уступает приведенным выше.

В философском энциклопедическом словаре (1983 г.) приведено: "Информация

(от лат. informatio - ознакомление, разъяснение, представление, понятие)

1) сообщение, осведомление о положении дел, сведения о чем-либо, передаваемые

людьми; 2) уменьшаемая, снимаемая неопределенность в результате получения

сообщений; 3) сообщение, неразрывно связанное с управлением, сигналы в

единстве синтаксических, семантических и прагматических характеристик;

4) передача, отражение разнообразия в любых объектах и процессах (неживой

и живой природы)" [18].

В "Философской энциклопедии (1970 г.) во втором томе читаем: "Информация (от латинского informatio - осведомление) - см. Теория информации [19]. А в пятом томе в статье "Теория информации" вместо дефиниций приводятся различные представления о количественной оценке информации. Дефиниции того, что собственно значит термин "информация" просто не дается. Аналогичная ситуация с перекрестными ссылками в энциклопедии описана польским сатириком Станиславом Леммом по поводу определения понятия "сепульки".

В связи с трудностями философского определения понятия "информация" возникло убеждение в том, что оно не может быть отнесено к разряду философских категорий с заменой ею отражения (П. Копнин [20].

Особое место в коллекции определений занимают утверждения о том, что информация - это алгоритм:

- "информация... есть план строения клетки и, следовательно, всего организма" [21]. Модификация этого определения содержится в работе Э. Янча,

трактовавшего информацию как "инструкцию" к самоорганизации

в процессе эволюции биологических структур [22].

В работе В. Корогодина [23] приводятся определения:

- "информация есть некий алгоритм" "совокупность приемов, правил или сведений, необходимых для построения оператора, будем называть информацией". Под словом "оператор" здесь понимается некое стороннее воздействие на систему, изменяющее спонтанный ход событий.

Большое число похожих и непохожих друг на друга определений понятия "информация" означает, что общепринятого определения ещё нет. Более того, нет даже четкого понимания сути этого явления, хотя потребность в нем уже назрела.

Сейчас область применимости информационного подхода существенно расширилась. Понятие "информация" используется при исследовании практически всех процессов самоорганизации (в частности биологической эволюции). При этом актуальным становится вопрос о возниковении информации и эволюции её ценности. Здесь без определения понятий уже не обойтись.

Выбор определения зависит от аппарата исследования, иными словами, определение

должно быть конструктивным, то есть пригодным для использования в рамках

аппарата. Мы будем использовать аппарат теории динамических систем, поскольку

именно он лежит в основе науки о самоорганизации (то есть синергетики).

Этим условиям в наибольшей степени удовлетворяет определение информации,

предложенное Генри Кастлером [24].

· Информация есть случайный и запомненный выбор одного варианта из нескольких

возможных и равноправных.

Здесь слово "случайный" выделено, поскольку оно относится к

процессу (способу) выбора и потому сужает область применимости определения.

Вообще говоря. выбор может быть и не случайным (подсказанным), в этом

случае говорят о рецепции информации. Случайный выбор соответствует генерации

(то есть спонтанному возникновению) информации.

Поэтому слово "случайный" мы в определении информации опустим,

но учтем его при обсуждении процессов генерации и рецепции.

Слово "запомненный" тоже выделено, поскольку в дальнейшем будет

играть очень важную роль. Оно относится к фиксации информации. Вообще

говоря выбор может и не запоминаться (то есть тут же забываться). Такой

выбор будем называть микроинформацией. Запомненный выбор (в отличие от

незапоминаемого) будем называть макроинформацией .

Во всех информационных процессах используется макроинформация (запоминаемая). Микроинформация используется главным образом в теор-физических спекуляциях по поводу "демона Максвелла" (о чем пойдет речь позже).

Поэтому далее под информацией мы будем понимать только запоминаемую информацию

и приставку "макро" опустим.

Слова "возможных и равноправных" означают, что варианты выбора

принадлежат одному множеству и априорные различия между ними не велики.

В идеале варианты могут быть полностью равноправны и равновероятны, но

могут и отличаться. В этом случае слово "равноправные" означает,

что априорные вероятности различных выборов - величины одного порядка.

С учетом сказанного примем определение информации в виде:

· Информация есть запомненный выбор одного

варианта из нескольких возможных и равноправных. (Q)

Далее мы будем использовать это определение и ссылаться на него как на

дефиницию (Q). Мы не настаиваем на оригинальности этого определения, более

того, считаем, что по духу и смыслу оно принадлежит Г. Кастлеру (откуда

и обозначение: Q - Quastler)

Определение (Q) отличается от предыдущих в следующем.

- Во-первых оно четко, понятно и широко используется в естественных науках. Конструктивность его проверена на многих примерах [25-28]. Это определение не противоречит предыдущим, когда речь идет о реальных задачах. Так, определение информации как инструкции или оператора в конкретных случаях сводится к указанию, какой именно выбор следует сделать в том или ином случае.

- Во-вторых согласно этому определению информация предстаёт как нечто конкретное

и "приземленное", ощущение чего-то "сверхестественного

и романтического в нем отсутствует, исчезает ореол "божественного".

Можно считать это недостатком определения, поскольку именно это ощущение

привлекает многих людей и вдохновляет их на подвиги (научные, не научные

и лже-научные).

Тем не менее, мы надеемся показать, что именно это определение позволяет понять такие тонкие явления как возникновение жизни и механизмы мышления с естественно-научной точки зрения. Иными словами - построить мост между естественными науками и гуманитарными. - В-третьих определение (Q) допускает введение меры - количества информации

( о чем пойдет речь позже).

Подчеркнем еще одну особенность определения (Q).

Слово "выбор" - отглагольное существительное. Его можно понимать в двух смыслах: как процесс и как результат процесса. Разница примерно такая же, как между судопроизводством и приговором суда. В определении Кастлера выбор понимается, как результат процесса, но не как сам процесс. Именно в этом смысле (то есть как "приговор") оно конструктивно и именно в этом смысле оно используется в реальных задачах.

Слово "процесс" в естественных науках прочно занято, оно означает изменение системы во времени (то есть "движение" её), которое в общем случае ещё не известно чекончится и кончится ли вообще. Согласно определению (Q) при этом информация еще отсутствует. Однако, информация как результат выбора не мыслима без прцесса выбора, как приговор не мыслим без суда. Отнюдь не любой процесс заканчивается выбором, Последнее возможно лишь в процессах определенного класса. Поэтому целесообразно ввести понятие "Информационный процесс", свойства которого мы обсудим позже.

В заключение этого раздела отметим, что в реальных задачах, как правило фигурирует не просто информация, а ценная или осмысленная информация (пока мы употребляем эти термины, апеллируя к интуиции читателя, определим их позже). Часто это упускают из внимания, полагая, что не ценная информация - вообще не информация. Последнее ведет к недоразумениям.

| 1.1.1. Количество информации |

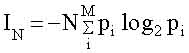

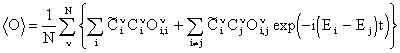

Эта величина была введена в 1948 году Клодом Шенноном [29] на примере текстового сообщения. Количество информации в сообщении, содержащем N символов IN, по Шеннону равно;

|

(1.1)

|

где M - число букв в алфавите, pi - частота встречаемости i-ой буквы в языке, на котором написано сообщение, знак " - " перед всей правой частью формулы (1.2) поставлен для того, чтобы Ii была положительной, несмотря на то, что logq pi < 0 ( pi < 1) . Двоичные логарифмы выбраны для удобства. При однократном бросании монеты М=2 ("орел" или "решка"), N = 1 и pi =1/2. При этом получаем минимальное количеств информации (I=1), которое называется "бит". Иногда в (1.1) используются натуральные логарифмы. Тогда единица информации называется "нат" и связана с битом соотношением: 1 бит = 1,44 ната.

Приведенные формулы позволили определять пропускную способность каналов связи, что послужило основанием для улучшения методов кодирования и декодирования сообщений, выбора помехоустойчивых кодов, словом, для разработки основ теории связи.

В этом примере текст можно рассматривать как результат выбора определенного

варианта расстановки букв.

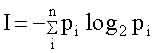

В общем случае, когда делается выбор одного варианта из n возможных (реализующихся

с априорной вероятностью pi i=1,2,...n), количество информации выражается

формулой:

|

; i=1,2, ... n. |

(1.2)

|

Если все варианты равновероятны, то есть pi =1/n , то:

I= log2 n (1,3)

В частном случае сообщения из N букв из бинарного алфавита (М=2) число

вариантов равно: n = 2N , количество информации I= N, что совпадает с

формулой (1.1).

На этом примере удобно пояснить, что означает слово "равноправные"

в определении (Q). Представим, что в тексте имеются символы, которые в

алфавите вообще не содержатся (не "буквы"). Априорная вероятность

такового считается очень малой ( pn+1 << 1/n) и в сумме (1,2) не

учитывается, поскольку он выпадает из рассматриваемого множества.

Отметим, что формула (1,2) отражает количество информации, но не ценность её.

Поясним это на примере. Количество информации в сообщении, определяемое формулой Шеннона, не зависит от того или иного сочетания букв: можно сделать сообщение бессмысленным, переставив буквы. В этом случае ценность информации исчезнет, а количество информации останется прежним. Из этого примера следует, что подменять определение информации (с учетом всех её качеств) определением количества информации нельзя.

Исторически сложилось так, что определение количества информации бвло предложено раньше, чем определение самой информации. Для решения ряда практических задач это было полезно. Однако, в дальнейшем подмена понятий часто приводила к недоразумениям.

Обсудим в связи с количеством информации ещё два понятия: "Информационная

тара" (термин введен В.И. Корогодиным [23]) и "Информационная

ёмкость". Первый связан с мощностью множества, из которого выбираются

варианты. Второй используется для физических систем, способных хранить

информацию. По смыслу они близки друг другу.

Поясним смысл их на примере текста. Если любое сочетание букв в тексте

является ценным, то количество ценной информации совпадает с полным количеством,

но не может превышать его. Это значит, что любая передача сигналов и/или

запоминающее устройство может содержать какое то количество ценной (или

осмысленной) информации (не больше, чем (1,2) но может содержать и меньшее

или не содержать вовсе. В этой связи количество информации в (1,2) можно

назвать информационной тарой. Это понятие играет существенную роль при

рецепции информации и/или при обработке её (в частности при перекодировке).

Приведем пример. Имеется текст на русском языке, содержащий Nr букв кирилицы (алфавит содержит 32 буквы). Перевод его на английский содержит Na букв латинского алфавита (26 букв). Русский текст - результат выбора определенного варианта из nr возможных (число вариантов порядка 32 в степени Nr ). Английский перевод - выбор определенного расположения латинских букв, который предопределен русским текстом (рецепция информации). Число вариантрв в английском текста порядка 26 в степени Na Количество ценной информации одинаково (если смысл не искажен), а количество информации различно.

Ниже, на примерах мы увидим, что процессы генерации, рецепции и обработки ценной информации сопровождаются "переливанием" информации из одной тары в другую. При этом, как правило. количество информации уменьшается, но количество ценной информации сохраняется. Иногда "информационные тары" столь различны. что можно говорить об информациях разного типа. Этот термин мы также будем применять к информациям, имеющим одинаковый смысл и ценность, но сильно различающихся количественно, то есть помещенных в разные тары.

В заключение раздела отметим, что сам Шеннон не разделял понятия информация

и количество информации, хотя и чувствовал. что это к добру не приведет.

"Очень редко, - писал Шеннон, - удается открыть одновременно несколько

тайн природы одним и тем же ключом. Здание нашего несколько искусственно

созданного благополучия слишком легко может рухнуть, как только в один

прекрасный день окажется, что при помощи нескольких магических слов, таких

как информация, энтропия, избыточность... нельзя решить всех нерешенных

проблем"[29].

| 1.1.2 Ценность информации. |

Ранее эпитеты "ценная", "осмысленная" употреблялись

без определения, в расчете на интуицию. В действительности эти понятия

являются центральными в современной информатике. Уместно сделать ряд замечаний.

Ценность информации зависит от цели, которую преследует рецептор.

Известны несколько способов количественного определения ценности. Все

они основаны на представлении о цели, достижению которой способствует

полученная информация. Чем в большей мере информация помогает достижению

цели, тем более ценной она считается.

1. Если цель наверняка достижима и притом несколькими путями, то возможно

определение ценности (V) по уменьшению материальных или временных затрат,

благодаря использованию информации. Так, например, сочетание хороших предметного

и алфавитного каталогов библиотеки, наличие библиографических справочников

сокращают время на составление списка литературы по конкретному интересующему

нас вопросу.

Этот метод определения ценности предложен Стратоновичем [30].

2. Если достижение цели не обязательно, но вероятно, то используется один

из следующих критериев:

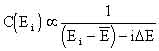

а) мерой ценности, предложенной М.М.Бонгартом [31] и А.А.Харкевичем [32], является:

|

V = log2 (P/p),

|

(1.3)

|

где p - вероятность достижения цели до получения информации, а P - после.

Априорная вероятность p зависит от информационной тары или. что то-же,

полного количества информации I в (1,2): p = 2-I . Так, если до получения

информации все варианты равновероятны, то p = 1/n (где: n - число вариантов,

а I = log2 n).

Апостериорная вероятность Р может быть как больше, так и меньше р. В последнем

случае ценность отрицательна и такая информация называется дезинформацией.

Примером последней может служить указатель на разветвлении дорог, который

по каким то причинам повернут в другую сторону. Таким образом вероятность

Р находится в пределах 0 < Р <1, и, соответственно, - <V<

Vmax

б) мерой ценности, предложенной В.И.Корогодиным [23], является величина

|

V = (P-p) / (1-p)

|

(1.4)

|

Она обладает теми же свойствами, что ценность (1,3), но изменяется от

0 до 1.

Мы далее будем использовать ценность, определенную в (1,4) поскольку оно

удобнее и более популярно.

ii) Согласно (1.3) ценность информации зависит от величины p - вероятности

достижения цели до получения информации, то есть, от того, какой предварительной

(априорной) информацией он уже располагает рецептор. Предварительная осведомленность

называется тезаурусом. Если таковая отсутствует, то априорная вероятность

во всех вариантах одинакова и равна p=1/n (где n - число вариантов). В

этом случае величина p играет роль нормировочного множителя. Если при

этом, после получения информации цель достигается наверняка (P=1), то

ценность этой информации максимальна и равна V= Vmax =log2 n, т.е. совпадает

с максимальным количеством информации в данном множестве (в данной таре).

Это совпадение не случайно, именно для этого была выбрана форма (1.3),

при этом ценность информации можно понимать как количество ценной информации.

iii) Количество информации, имеющий нулевую ценность, как правило, не

мало по сравнению с количеством информации, имеющих хоть какую-то ценность

(положительную или отрицательную). Например: пусть цель - узнать прогноз

погоды, а по радио (или телевизору) передают : кто выиграл в футбол, кто

в теннис, что случилось в Санта-Барбаре и т.д. Для Вас все это имеет нулевую

ценность, хотя для другого, возможно, ценна наоборот именно эта информация.

Отсюда следует, что ценность информации субъективна.

Существует информация которая , на первый взгляд, ни для кого и никогда

не может стать ценной. Пример: в тексте наборщик переставил буквы так,

что текст потерял всякий смысл. Количество информации сохранилось, но

ценность его для кого бы то ни было, стала равна нулю.

Так появляется понятие "осмысленность". В отличие от "ценности"

это понятие претендует на объективность, что основано на следующем положении:

в информационной таре, куда вмещена данная информация, можно выделить

определенное количество информации, которая никогда ни для кого ни для

какой -либо цели не понадобится. Тогда эту информацию называют лишенной

смысла. Объективность критерия основана на утверждениях : "ни для

кого, никогда, ни для какой цели".

Утверждение сильное, абсолютное и, как таковое, конечно, не верное. Так,

в приведенном примере можно сказать, что абракадабра, которую сотворил

наборщик содержит ценную информацию для психиатора, цель которого - поставить

наборщику диагноз. Поэтому утверждение "ни для кого" следует

принимать: ни для кого среди людей, которых интересует смысл текста и

ничего более. Однако, и в этом случае осмысленность текста зависит от

тезауруса. Так, например, наборщик набрал слова "трах-тибидох-тах-тах".

На первый взгляд это бессмыслица, однако, люди сведующие знают, что смысл

в этих словах есть, поскольку именно с их помощью старик Хаттабыч творил

чудеса.

Мы остановились на этом вопросе столь подробно по следующим причинам.

Во-первых в традиционной информатике, основанной на математической теории

связи, не существует и не обсуждаются вопросы о возникновении ценной информации

и ее эволюции. Ценность информации обсуждается в предположении о том,

что цель задана извне. Вопрос о спонтанном возникновении цели внутри самой

системы там не ставится.

Сейчас в связи с развитием науки о самоорганизации (синергетики) именно

эти вопросы стали актуальными, особенно в проблеме биологической эволюции.

Именно они являются предметом динамической теории информации.

При этом, как будет показано позже, ценность информации эволюционирует:

не ценная информация становится ценной, бессмысленная - осмысленной и

наоборот.

Во-вторых, люди невольно отождествляют просто информацию с ценной и (или

осмысленной), что приводит к недоразумениям. Эта тенденция проявляется

в коллекции определений информации.

Действительно, если отождествить понятия информация и ценная информация,

то дать объективное и конструктивное определение такому феномену, в принципе

невозможно. Напротив, разделив эти понятия, можно дать конструктивное

определение каждому из них, оговорив меру условности и субъективности.

|

1.2. Рецепция и генерация информации.

|

Рецепция информации - выбор, продиктованный свыше, т.е. по указанию кого-

либо или чего - либо. Иными словами, речь идет о выборе, сделанном на

основании информации, которую данный человек (или система) принимает (название

происходит от recept - принимать).

На языке теории динамических систем рецепция информации означает перевод

системы в одно определенное состояние независимо от того, в каком состоянии

она находилась раньше. В современных технических устройствах рецепция,

как правило, осуществляется с помощью электрического или светового импульсов.

Во всех случаях энергия импульса должна быть больше барьера между состояниями.

В теории динамических систем такое переключение за счет сторонних сил

называется силовым. Наряду с ним существует и используется другой способ

переключения - параметрический. Суть последнего в том, что на некоторое

(конечное) время параметры системы изменяются настолько, что она становится

моностабильной (то есть одно из состояний становится неустойчивым, а затем

исчезает). Независимо от того, в каком состоянии находилась система, она

попадает в оставшееся устойчивое состояние. После этого параметрам возвращают

их прежние значения, система становится бистабильной, но остается в новом

состоянии.

Параметрическое переключение, как и силовое, является рецепцией информации;

отличаются лишь механизмы переключения, то есть рецепции. В современной

электронике применяется преимущественно рецепция информации за счет силового

переключения. В биологических системах, напротив, преимущественно используется

параметрическое переключение. Последнее может быть достигнуто неспецифическими

факторами (изменением температуры, рН и др.). Иными словами, неспецифические

факторы могут играть роль переключателей - носителей рецептируемой информации.

Генерация информации - выбор. сделанный случайно, без подсказки извне.

В обоих случаях, как рецепции, так и генерации, способность воспринимать

или генерировать зависит от информации, которую уже содержит рецептор

или генератор.

В связи с этим уместно обсудить иерархию уровней информации в развивающихся

системах.

|

1.2.1. Иерархия информационных уровней

|

Сперва приведем пример. Учась говорить, ребенок рецептирует информацию

об языке от своего окружения, преимущественно от родителей. Овладев языком

и грамотностью молодой человек оказывается перед выбором свой будущей

специальности. Сделав свой выбор и овладев специальностью, человек в дальнейшем

может неоднократно выбирать, в каком направлении приложить усилия. При

этом новые выборы возможны только на основе прежних, более ранних, так

как делаются человеком, владеющим не только языком, но и специальностью.

Каждый выбор делается либо случайно, либо под влиянием внешних событий,

которые часто, на первый взгляд, не относятся к делу.

Ценная информация, которой мы пользуемся повседневно и которую порой генерируем,

принадлежит верхнему уровню. Для ее восприятия или генерации необходимо

владеть языком (хотя бы одним) и знаниями (например, математикой, информатикой

и т.д., в зависимости от профессии), т.е. обладать тезаурусом.

Каждый раз выбор делается с целью, которая ставится в данный момент, она

и определяет ценность информации. Однако, все промежуточные, сиюминутные

цели подчинены одной главной цели.

Какова она? Иными словами, какова цель жизни и в чем счастье?

Этим вопросам посвящены тома художественной и философской литературы.

Мы тоже обсудим их, но позже, когда речь пойдет о возникновении жизни

и появлению у живых существ способности к целеполаганию.

Возвращаясь к вопросу об иерархии информаций, отметим , что тезаурус -

информация, содержащаяся в системе на данном уровне, необходимая для рецепции

(или генерации) информации на следующем уровне.

Поясним сказанное на языке теории динамических систем. При этом придется

использовать понятия и термины, смысл которых будет пояснен в следующей

главе. Тем не менее. считаем это целесообразным ради слитности изложения.

В развивающейся системе необходимость выбора возникает, когда она приходит

в неустойчивое состояние, т.е. находится в точке бифуркации (для определенности

будем считать эту бифуркацию I-ым уровнем). Выбор делается из множества

различных вариантов, мощность и характер которого определяется типом бифуркации.

В простейшем случае выбор делается из двух вариантов.

После сделанного выбора система развивается устойчиво вплоть до следующей

бифуркации. Здесь снова делается выбор, но уже из другого множества вариантов

(II-ой уровень). Это множество зависит от результата первого выбора. Если

система в своем развитии ещё не дошла до первого этапа. то вопрос о выборе

варианта на втором этапе вообще теряет смысл. Иными словами, информация

первого уровня является тезаурусом для второго и всех последующих уровней.

Отсюда ясно, какую роль играет тезаурус в процессе генерации ценной информации.

Без него отсутствует множество, из которого надлежит сделать выбор. Выбор

из любого другого множества будет иметь нулевую ценность.

Несколько сложнее обстоит дело в случае рецепции информации. В простейшем

случае информация, поступающая извне, определена на том же множестве вариантов,

из которого делается выбор. Именно так обстоит дело в упомянутом выше

примере рецепции языка от родителей. Необходимый для этого тезаурус у

ребенка присутствует от рождения.

На более высоких уровнях информация, поступающая со стороны, имеет отношение

ко всем уровням, а не к данному. Тезаурус необходим для того, чтобы выделить

из неё ценную информацию, относящуюся к данному уровню. Для иллюстрации

этого приведем пример, (заимствован у Ю.М. Шрейдера, цитируется по [31]).

"Имеется второй том "Курса высшей математики" В.И.Смирнова.

Эта книга содержит богатую информацию. Какова ее ценность? В ответ приходится

спросить - для кого? Для дошкольника ценность этой информации нулевая,

так как он не обладает достаточной подготовкой, достаточным уровнем рецепции

и не в состоянии эту информацию воспринять. Для профессора математики

ценность тоже нулевая, так как он все это хорошо знает. Максимальной ценностью

эта информация обладает для студентов того курса, которым книга предназначена,

- поскольку речь идет об очень хорошем учебнике".

В этом примере множество, на котором сформулирован курс высшей математики,

, к уровню дошкольника не относится, поскольку он ещё не дорос до этого.

Что касается профессора, то в примере Шрейдера он знает всё, и никаких

целей перед собой уже не ставит. Поэтому любая информация, в том числе

и учебник Смирнова, имеет для него нулевую ценность.

Особого внимания заслуживает ситуация, когда множество вариантов на следующем уровне ещё не сформировано, хотя цель уже поставлена. Именно так обстоит дело, когда речь идет об исследовании и описании нового явления. Тогда поступающая извне информация не помогает сделать выбор (поскольку выбирать ещё не из чего), но может помочь сформировать нужное множество. В упомянутом примере этому соответствует четвертый участник - ученый. В отличие от первых трех (дошкольник, студент, профессор), он не только знает учебник, но и может ставить вопросы, ответы на которые в учебниках отсутствуют. Из разговоров с коллегами и чтения книг ученый получает большое количество посторонней информации, которая относится к другим задачам. При достаточном тезаурусе ученый может рецептировать эту информацию, переработать её и сформулировать нужное множество, содержащее всего два варианта, таких, что выбор одного из них приближает к достижению цели. В науке это называется постановкой вопроса. Когда вопрос поставлен (множество сформулировано), та же посторонняя информация может помочь выбрать вариант, то есть генерировать ценную информацию. Из этого примера видно, что рецепция и генерация информации тесно связаны друг с другом. Позже мы рассмотрим этот вопрос детальнее на примере игры в рулетку.

| 1.2.2. Условная и безусловная информация |

Объект, зафиксировавший ту или иную информацию, является ее носителем. Информация, не будучи "ни материей, ни энергией", может существовать только в зафиксированном состоянии. При этом способы фиксации (записи) могут быть условными, не имеющими отношения к семантике. Отсюда возникает необходимость деления информации на условную и безусловную. Пример условной информации - код, которым пользуются, чтобы зашифровать сообщение. Кодом называется соответствие между условными символами и реальными предметами (и/или действиями). Выбор варианта кода производится случайно и запоминается как передающей, так и принимающей стороной. Ценной кодовая информация может быть только если ею владеет несколько объектов (человек), то есть эта информация связана с коллективным поведением (общественной деятельностью).

Условной является также информация, содержащаяся в алфавите и словарном

запасе языка.

Кодовой является и условная генетическая информация, о которой речь пойдет

в 4-ой главе. Генетику удается свести к формальному описанию явлений в

терминах языка, причем весьма жесткого и закрытого. В словаре этого языка

не происходит изменений, ибо любые изменения словаря приводят к летальному

исходу для носителя информации. Замечательно, что в отличие от обычных

языков (специалисты насчитывают 3000 различных разговорных языков!) генетический

код един. Его структура одинакова как для человека, так и для растений.

Безусловной является информация о реально происходящих событиях. Она не

нуждается в согласовании и может рецептироваться информационной системой

даже без участия человека. Эта информация не возникает случайно, ибо она

рецептируется из окружающей действительности.

Например, утверждение о том, что в такое-то время в таком-то месте произошло

землетрясение является безусловной информацией. В основе самого события

- случайность, выбор, но зафиксировано оно с помощью сейсмографов многими

сейсмостанциями Земли вполне закономерно (приборы настроены на запись

колебаний почвы). Наблюдатели узнают о событии из сейсмограмм. Рецепция

события таким образом не содержит элемента случайности.

Для пояснения сказанного приведем еще один пример. Допустим, что один

астроном открыл, наблюдая, новую звезду - это безусловная информация.

Другой астроном ничего не открывал, но придумал для нее название - это

генерация условной информации. Часто бывает так, что второй оказывается

более популярен и именно ему приписывается честь открытия.

Сообщения могут содержать как условную, так и безусловную информацию,

разделить их не всегда просто. Здесь играют роль следующие обстоятельства.

Первое. Условная информация имеет тенденцию к унификации, что естественно,

поскольку при этом возрастают ее ценность и эффективность. Эта тенденция

более выражена на нижних уровнях как эволюционно более древних. Так, например,

математический формализм унифицирован на нижних уровнях иерархической

информационной лестницы.

Второе. Унифицированная условная информация часто воспринимается как безусловная.

Так, унифицированная на нижнем уровне математика, включающая арифметику,

создает мнение о том, что "иначе не может быть". Однако унификация

математического аппарата произошла в результате эволюции. При этом были

в употреблении варианты, отличающиеся от современного.

На более высоких уровнях существует несколько различных вариантов описания

одних и тех же объектов: континуальное описание, динамические уравнения,

вероятностные модели, клеточные автоматы и т.д. Во многих случаях вопрос

о предпочтении того или иного варианта остается открытым. Поэтому выбор

математического аппарата - акт генерации ценной условной информации.

В принципе математика - аксиоматизированная область знаний, что делает

ее единой наукой, имеющей свою логическую структуру. Идеал языка такой

науки - это система правил оперирования со значками. Чтобы задать "исчисление",

необходимо составить алфавит первичных элементов - знаков, задать начальные

слова исчисления, построить правила получения новых слов. Математическая

мысль и система кодов неразделимы. Символы имеют для математика принципиальное

значение. Так, методологические установки Гильберта согласно Клини основаны

на том, что символы сами по себе являются окончательными предметами и

не должны использоваться для обозначения чего-либо, отличного от них самих.

Математическое знание содержится в кратких высказываниях - математических

структурах. Возникает вопрос: содержат ли новую информацию доказательства

теорем? Вопрос не тривиален. С одной стороны, доказательство теорем приводится

как классический пример творчества (то есть генерации информации). С другой

стороны, теорема - следствие аксиом и, следовательно, не содержит новой

(по сравнению с аксиомами) информации. Доказательство теоремы есть извлечение

ценной информации из аксиом, то есть рецепция. Тем не менее, творческий

элемент при доказательстве теорем, конечно, присутствует. Он связан с

выбором пути доказательства. Как правило теорема может быть доказана несколькими

способами. Выбор наиболее простого и доступного пути - генерация ценной

информации.

Третье. Наиболее интересным и острым остается вопрос об условности (или

безусловности) информации в естественных науках. Принято думать, что,

изучая природу, мы рецептируем безусловную, вполне объективную информацию.

Это действительно так, если речь идет об экспериментальных качественных

результатах.

Например, информация о том, что одноименные заряды отталкиваются, а разноименные

притягиваются, является безусловной. Математическое описание этого явления

в виде закона Кулона было сформулировано на определенном языке (векторной

алгебре). Выбор языка (кода) всегда условен. Можно было бы описать это

явление на языке дискретных множеств или игр автоматов. Поэтому выбор

математического языка - пример генерации условной информации.

Научное творчество в области естественных наук содержит два необходимых

элемента: рецепцию безусловной информации от природы и генерацию условной

(теоретической) информации. Успех зависит от того, в какой мере выбранный

алгоритм описания уже принят в научном сообществе, то есть от тезауруса

этого сообщества.

| 1.3 Макро и микроинформация, ошибочность термодинамической трактовки информации. |

Начиная с работ по классической теории информации, установилась традиция

связывать информацию с термодинамической величиной - энтропией. Начало

этой традиции было положено Н. Винером, увидевшем действительно бросающееся

в глаза сходство формул Шеннона для количества информации I и формулы

Больцмана для энтропии S. Различие в размерности устранялось выбором единиц

измерения I, которое можно измерять и в энтропийных единицах.

В дальнейшем появилось слово "негоэнтропия" и утверждение: "информация

есть негоэнтропия" Эти слова многократно повторялись в научных статьях,

книгах и даже в учебниках. У людей, занимающихся конкретными проблемами

информатики эти слова вызывали (и продолжают вызывать) недоумение и раздражение

(внутренний дискомфорт), потому, что "что-то в здесь не так".

В этом разделе мы обсудим что именно "не так" и почему.

Согласно определению (Q) информация есть запомненный выбор (т.е. макроинформация).

На физическом языке "запомнить", то есть зафиксировать информацию,

означает привести систему в определенное устойчивое состояние. Ясно, что

таких состояний должно быть не меньше двух. Каждое из них должно быть

достаточно устойчивым, в противном случае система может самопроизвольно

выйти из того или иного состояния, что равносильно исчезновению информации.

Простейшая запоминающая система содержит всего два устойчивых состояния

и называется триггер (переключатель). Этот элемент играет важную роль

во всех информационных системах.

В электронике в качестве запоминающего триггера используют магнитные домены

(размеры порядка микрон), а также электрические и светочувствительные

ячейки (тоже микронных размеров).

Свойством запоминания могут обладать только макроскопические системы,

состоящие из многих атомов. Запомнить что-либо, располагая одним атомом,

невозможно, поскольку атом может находиться лишь в одном устойчивом (основном)

состоянии. То же относится и к простейшим молекулам. Наименьшая по своим

размерам самая простая система, которая может запомнить один вариант из

двух возможных, это молекула, способная находиться в двух различных изомерных

состояниях при условии, что спонтанный переход из одной формы в другую

может происходить так редко, что его вероятностью практически можно пренебречь.

Примером таких молекул могут служить оптические изомеры, обладающие "левой"

или "правой" киральностью, различающейся по способности содержащих

их растворов вращать вправо или влево плоскость поляризации света, пропускаемого

через растворы. К таким оптическим изомерам относятся сахара и аминокислоты,

содержащие десять-двадцать атомов.

Молекулярными триггерами могут служить макромолекулы (в частности, белковые

молекулы), способные существовать в нескольких (по крайней мере двух)

конформационных состояниях.

Системы более высокого иерархического уровня, такие как клетка, популяция,

организм, мозг, разумеется, тоже могут быть запоминающими. Механизм запоминания

при этом не всегда сводится к генетическому (то есть макромолекулярному).

Например, клетка (в частности, нервная), способная функционировать в двух

и более устойчивых состояниях, уже является запоминающим устройством.

Тоже можно сказать о популяции и организме. Механизм запоминания в нервных

сетях (в частности, в мозге) имеет свои особенности, которые мы обсудим

позже.

Важную роль играет время запоминания. В устойчивых динамических системах

оно формально бесконечно. Переключить триггер из одного состояния в другое

можно лишь за счет стороннего сигнала, что равносильно рецепции (см. выше).

В реальности возможно спонтанное переключение (т.е. забывание исходного

состояния) за счет случайных флюктуаций. Вероятность спонтанного переключения

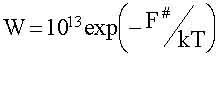

в единицу времени зависит от величины флюктуаций и высоты барьера F# между

состояниями. В термодинамически равновесных (по микроскопическим степеням

свободы) условиях эта вероятность равна:

|

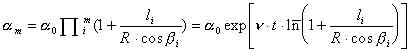

Где: 1013 сек-1 - частота тепловых флюктуаций. Время запоминания Т= 1/W.

При F# порядка 1.5 эВ время Т= 3·105 лет, что практически можно считать

бесконечным.

Мы остановились на этом столь подробно, чтобы продемонстрировать:

Во-первых, макроинформация может содержаться только в макрообъектах.

Во-вторых, граница между макро и микро объектами проходит на уровне макомолекул,

размеры которых порядка нанометров (10-9 метра или 10-7 сантиметра). Современная

наноэлектроника подбирается к этой границе.

Наряду с макроинформацией выше упоминалось о микроинформации, которой

соответствует выбор принципиально не запоминаемой. Примером последнего

может служить выбор одного микросостояния идеального газа в состоянии

термодинамического равновесия. Выбор микросостояния означает, что нам

удалось в определенный момент времени t изменить координаты и скорости

всех молекул с определенной точностью. Разумеется, это возможно лишь умозрительно,

но и в этом случае выбранное состояние тут же (за время t~10-13 сек) ,

будет забыто, то есть сменится другим микросостоянием, выбранным по закону

случая. Это свойство - забывать предыдущее микросостояние - является фундаментальным

для эргодических систем. в которых средние по времени совпадают со средними

по ансамблю. Именно оно понимается под словами "молекулярный хаос"

и именно оно лежит в основе термодинамики.

Количество микроинформации в данном примере велико, согласно (1.3) оно

равно:

|

Imicro=log2n=-log2W,

|

(1.5)

|

где, nmicro число микросостояний , W=1/nmicro - вероятность случайно

выбрать какое-либо одно из них. Количество макроинформации в том же примере,

напротив мало; именно Imаcro= log2 nmаcro = 0, поскольку макросостояние

равновесного газа единственно, то есть nmаcro = 1.

Разумеется, макроинформация не может быть ни ценной ни смысловой и вообще

не может использоваться, как информация в реальной жизни. Тем не менее

она широко обсуждается и является источником многих недоразумений.

Причину тому следующий:

Во-первых, формула (1.5) следующая из формулы Шеннона, очень похожа на

формулу Больцмана для энтропии

.

|

|

(1, 6)

|

Где k=1,38 10-23 Дж/град. - постоянная Больцмана.

Поэтому микроинформация и энтропия пропорциональны друг другу:

|

|

(1.7)

|

В действительности формула (1.7) представляет собой связь между энтропией

и микроинформационной емкостью (или "тарой"), поскольку сравниваются

энтропия до измерения (S(t)) и количество микроинформации после измерения

I(t+t).

Можно , (только умозрительно) оценить энтропию сразу после измерения,

то есть до того как наблюденное состояние разрушится (т.е. в течение t

@ 10-13 сек). С точки зрения термодинамики нахождение макросистемы в одном

микросостоянии - колоссальная флюктуация. Энтропия ее много меньше равновесной

энтропии S (до измерения). Именно:

|

S(t+t)=k ln W(t1t+t)

|

(1.8)

|

где W(t1t+t) - условная вероятность того, что в момент t+t будет наблюдено

то же макросостояние, которое реализовалась в момент t. Ясно, что W(t1t+t)=1

и S(t+t)=0.

Отсюда следует, что в результате измерения энергия уменьшалась на величину

DS=S(t+t)-S(t)=-S(t)

Количество информации до измерения, когда выбор еще не сделан Imicro(t)=0

, поэтому прирост количества макроинформации D Imicro=+ Imicro

Отсюда делается вывод:

|

|

(1.9) |

Интерпретация выражения (1.9) такова: при увеличении информации о системе

ее энтропия уменьшается. Отсюда же происходит крылатое выражение "информация

есть негоэнтропия".

Во-вторых микроинформацию и энтропию связывает еще "демон" Максвелла.

Демон впервые появился более ста лет тому назад (в 1871 г.) в книге К.

Максвелла "Теория теплоты", как парадокс, демонстрирующий возможность

арушения второго начала термодинамики.

Напомним суть дела. Имеются два сосуда с газом при исходно одинаковой

абсолютной температуре Т. Они разделены перегородкой, в которой имеется

отверстие с заслонкой. Заслонкой управляет "демон", он фиксирует

скорости и в одну сторону пропускает только быстрые молекулы, а в другую

- только медленные. В результате через некоторое время в одном сосуде

температура повышается, а в другом - понижается. Таким образом, тепло

переходит от холодного тела к более теплому без совершения работы (на

первый взгляд) - второе начало нарушается и энтропия уменьшается.

Разрешение парадокса было предложено известным физиком, много сделавшем

дл развития теории конденсированных сред, Леоном Бриллюеном . Он показал,

что даже демон бесплатно ничего не делает (так уж устроен наш мир). Для

фиксации скорости молекулы, т.е. получению информации, демону нужно заплатить

энергией, не меньшей, чем энергия теплового кванта kT (при комнатной температуре

Т=300оК, kT= 0,025 эВ). Энергия kT/1,44 - минимальная цена одного бита

микроинформации (1,44 - коэффициент перехода от натуральных логарифмов

к двоичным). После этого стало ясно, что демон совершает работу и как

раз такую, которая необходима для охлаждения одого тела и нагревания другого.

По существу любой домашний холодильник работает как демон и за это тоже

нужно платить.

При этом демон получает информацию равную уменьшению энтропии. Так возникло

утверждение: "информация есть негоэнтропия". Приставку "микро"

при этом по недосмотру опустили, а зря, поскольку именно это привело к

серьезным недоразумениям.

Разрешение парадокса всегда вдохновляет. Поэтому среди физиков - последователей

Бриллюена - демон и слово "негоэнтропия", как синоним информации,

стали часто употребляться - возник миф о негоэнтропии.

Справедливости ради, следует заметить, что Бриллюэн различал свободную

информацию (не давая ей, к сожалению, четкого определения) и связанную

информацию, возникающую, когда возможные случаи "могут быть представлены

как микросостояния физической системы". И далее: "Только связанная

информация будет представляться связанной с энтропией". Отсюда ясно,

что, во-первых, на деле Бриллюэн не приписывал любой информации свойства

негэнтропии, а во-вторых, ограничивал свое рассмотрение только той частью

информации, которая связана с микросостояниями. Так что к недоразумению

привели не сам Бриллюен, а его эпигоны.

После этих разъяснений формализм Бриллюэна выглядит очень просто и результаты

расчетов соответствуют (1,9).

Реально ни физического, ни информационного содержания термин "негэнтропия"

не имеет (он от "демона"). Что же касается той информации, которой

занимался Бриллюэн, то сам он называл ее "связанной"; в отечественной

литературе принят термин "микроинформация".

Микроинформация существенно отличается от макроинформации, поскольку она

не имеет важного для информации свойства фиксируемости, ибо незапоминаема.

Макроинформация существенно отличается от микроинформации не только качественно,

но и количественно. Это ясно, если вернуться от энтропийных к обычным

единицам измерения информации - битам.

|

Iмикро = - (DS/k)log2e = - 1,44 DS/k

|

(1.12)

|

Iмикро - огромное число, ибо k = 1,38 Ч10-23 Дж/К (DS < 0) ,

Iмaкро << - (DS/k)log2e

Причина этого неравенства в том, что запоминание - процесс макроскопический

и диссипативный, он сопровождается большим изменением энтропии.

Количественное различие ясно из следующих соображений.

Формула (1.3) справедлива как для микро-, так и для макроинформации, но

существенно различны числа возможных вариантов n . В случае макроинформации

n - число устойчивых состояний системы, оно, как правило, невелико. В

случае микроинформации n - полное число микросостояний, (неустойчивых,

то есть микроскопических) - оно огромно.

Яркий пример тому приведен в книге Блюменфельда "проблемы Биофизики"

[25]. Показано, что вся информация, заключенная в человеке (включая ДНК,

белки, а также мысли, как тайные, так и явные), будучи выраженной в энтропийных

единицах, соответствует энтропии испарения одного пол-литра кипяченой

воды (на самом деле, не так уж важно, чего именно)

Всякий раз, когда в акте творчества создается новая ценная информация,

мы имеем дело с макроинформацией. Из книг, лекций, природы мы рецептируем

макроинформацию. Вообще в реальной жизни, в частности, в биологии всегда

используется макроинформация, которую мы в предыдущих и в последующих

разделах называем просто информацией.

Любое изменение макроинформации, увеличение или уменьшение, сопровождается

ростом энтропии, что естественно, поскольку эти процессы необратимы. Количественной

связи между изменениями макроинформации и физической энтропии не существует.

Энергетическая цена макроинформации, конечно, существует, она определяется

энергией, диссипирующей в процессе запоминания и зависит от конкретных

условий, в частности от времени на которое информацию нужно запомнить,

то есть от свойств ячейки памяти. Эта энергия, приходящаяся на один бит

информации, заведомо (и много) больше кТ/1,44 - энергии одного бита микроинформации.

Таким образом, слово негоэнтропия - появилось в результате непониманя

роли условия запоминания информации. Слово негоэнтропия - пример условной

информации, которая в действительности не ускорила, а, напротив, затруднило

исследование информационных процессов, то есть оказалась на деле дезинформацией.

Именно от этого предостерегал Шеннон, слова которого мы уже приводили

выше.

В заключение раздела обсудим ещё одно недоразумение, связанное с понятием "порядок". Часто можно встретить утверждение о том. что информация

- мера упорядоченности, оно фигурирует даже в коллекции определений.

Это утверждение воспринимается как объективное (безусловное). На самом

деле требуется уточнить. какая именно информация (ценная или нет, условная

или безусловная) имеется в виду. Надо уточнить также, что понимается под

словом "порядок". Без этих уточнений утверждение теряет смысл.

В действительности в приведенном утверждении неявно предполагается, что

информация ценная, но в этом случае она наверняка условная, ибо зависит

от цели.

Понятие "порядок" тоже целесообразно. Так, если цель - прогноз,

то упорядоченными следует считать системы, развивающиеся устойчиво и допускающие

предсказание результатов. Именно в этом смысле в физике хаотические системы

считаются беспорядочными и энтропия здесь выступает как мера беспорядка.

В более общем случае, когда преследуются иные цели, меняется и смысл слова "порядок".

Для иллюстрации приведем пример из жизни.

Пусть некто (писатель или ученый) пишет книгу. Для этой цели он расположил

материалы в определенном порядке: рукопись - на столе, черновики - под

столом, статьи и книги - на стуле и диване. В кабинет входит жена и приходит

в ужас, поскольку у неё другие цели и другое представление о порядке.

Представьте, что ученый отлучился на время, а когда вернулся жена встретила

его радостными словами: "я, наконец-то навела порядок в твоем кабинете".

Представить состояние ученого в этот момент уже не трудно.

Из этого примера следует, что порядок - понятие условное в той же мере,

как и ценная информация.

Утверждение: "Ценная информация есть мера условного порядка"

имеет четкий смысл, оно правильно и. более того, банально. Отсюда ясно,

что искать объективную меру объективного порядка бессмысленно, ни того,

ни другого просто не существует.

В действительности проблема порядка и хаоса имеет много аспектов и к ней

мы ещё вернемся в гл. 7.

В заключение главы отметим, что:

Все (или почти все) определения, приведенные в "коллекции" имеют

смысл и относятся к разным сторонам информационного процесса.

Объединить эти определения, увидеть общую картину информационного процесса

и понять суть феномена информации позволяет теория динамических систем,

или, что то же, синергетика.

Это не случайно, развивающиеся сложные системы имеют много аспектов. В

гуманитарных науках это свойство предстоит как многоликий образ - термин

яркий эмоциональный, метафорический, но не четкий. В синергетике то же

предстоит вполне конкретно, как мультистационарность [27] или, что то

же, многовариантность [34], многомодальность [35], В синергетике эти понятия

формулируются четко и конструктивно, так, что с ними можно работать

|

Глава 2. УСТОЙЧИВОСТЬ ДИНАМИЧЕСКИХ СИСТЕМ И ПРОБЛЕМА

НЕОБРАТИМОСТИ.

|

Одна из особенностей нелинейной динамики открытых неравновесных систем (синергетики) состоит в том, что она имеет дело с неожиданными событиями. Эти события проявляют себя как качественные скачкообразные изменения состояния системы или режима ее развития в ответ на монотонное и медленное изменение параметров. При анализе всякий раз выясняется, что причиной неожиданности оказывается неустойчивость.

| 2.1. Динамические уравнения и фазовые портреты нелинейных систем: |

В этом разделе мы приведем основные сведения и поясним понятия теории

динамических систем (или, что то же , качественной теории дифференциальных

уравнений). Полное изложение можно найти в соответствующих математических

учебниках [1-5]. Популярное изложение содержится в книгах [6 - 9]

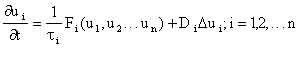

Теория динамических систем, основана на дифференциальных уравнениях вида:

dui/dt = (1/ti) Fi(u1 , u2, ...un) , (2.1)

где ui - динамические переменные, например, концентрации реагирующих веществ,

Fi(ui) - нелинейные функции, описывающие их взаимодействие. ti - характерные

времена изменения переменных ui , i = 1, 2, ... n.

Уравнения (2.1) являются динамическими, то есть при задании конкретного

вида функции Fi их решения, вообще говоря, однозначно определяются начальными

условиями Казалось бы в такой ситуации ничего неожиданного быть не должно.

Тем не менее характерные для синергетики неожиданности здесь возникают,

когда решения динамических уравнений теряют устойчивость.

Анализ устойчивости уравнений движения (изменения), а также устойчивости

стационарных состояний основан на исследовании поведения малых отклонений

от соответствующего решения . Покажем это на примере стационарных состояний

системы частиц (точек).

Стационарными называются состояния, соответствующие таким значениям переменных

u1 , u2, ...un , при которых все функции Fi(u1 , u2, ... un) равны нулю.

При этом значения ui не меняются со временем, так как все производные

(см. 2.1) также равны нулю. Однако малые отклонения от стационарных значений

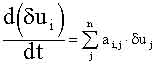

dui изменяются со временем, и их изменение можно описать системой линейных

дифференциальных уравнений:

|

(2.2)

|

|

|

где: | при uj = `uj , `uj - стационарные значения переменных. |

Решения системы (2.2) имеют вид:

|

|

(2.3) |

Здесь коэффициенты ei i определяются из условий:

|

|

(2.4) |

Откуда следует, что они пропорциональные начальным отклонениям, (e ~

du(0)) и малы в меру малости последних. Величины li - числа, которые являются

решениями алгебраического уравнения: det| ai,j - dij li| = 0, где dij

- символ Кронекера такой, что dij = 0 , если i № j и dij = 1 при i = j.

Величины li играют важную роль в теории устойчивости, их называют числами

Ляпунова.

Если числа Ляпунова отрицательны, то все dui(t) убывают со временем, поэтому

состояние устойчиво. В этом случае система стремится обратно к стационарному

состоянию, даже, если ее немного отклонить от него. Если хотя бы одно

из чисел Ляпунова положительно, то состояние неустойчиво.

В общем случае числа Ляпунова могут быть комплексными. Устойчивость определяется

тогда знаком действительной части. Если среди чисел Ляпунова имеются равные

нулю или чисто мнимые, то стационарное состояние называется нейтральным;

при отклонении от него не появляются ни возвращающие, ни отклоняющие силы.

Анализ неустойчивых движений основан на том же принципе: определяется

временнaя зависимость малых отклонений от заданной траектории. Используются

линейные по отклонениям уравнения (высшими степенями dui(t) пренебрегают),

решения которых имеют вид:

|

|

(2.5)

|

Числа Ляпунова при этом уже не постоянны, а зависят от времени. Траектория

является неустойчивой, если среди чисел li(t) имеются такие, вещественные

части которых положительны в достаточно большом интервале времени Dt,

таком. что Dt l(t) >> 1.

Подчеркнем важное свойство: числа Ляпунова являются характеристическими

(или собственными) числами системы; они не зависят от начальных условий.

Таким образом, устойчивость (или неустойчивость) - внутреннее свойство

исследуемой системы, а не результат внешнего воздействия. Особенность

его в том, что проявляется оно только при наличии малых внешних воздействий.

Эта особенность привела к важным методологическим последствиям. Сейчас

приходится пересматривать и подвергать ревизии некоторые, казалось бы

установившиеся в физике понятия. Обсудим три примера.

Рассмотрим понятие абсолютно изолированной системы. Сейчас ясно, что его можно (и то не всегда) ввести лишь как предел неизолированной системы при стремлении к нулю величины внешнего воздействия. Для устойчивых систем такой предел существует и, следовательно, понятие остается в силе. В неустойчивых системах такой предел, вообще говоря, не существует. Действительно, предел величины du(t) = eЧ еlt (где l > 0) при e ® 0 и t ® µ зависит от порядка стремления аргументов к своим пределам. Формально величину e (которая отражает меру внешних воздействий) и время t можно считать независимыми. Однако, как мы убедились на конкретном примере, уже при сравнительно небольших временах фактор еlt возрастает столь сильно, что компенсировать его уменьшением e - задача абсурдная. Суть дела здесь в том, что экспоненциальная зависимость (explt) очень сильна, конкурировать с ней практически невозможно. Поэтому для неустойчивых систем понятие "абсолютно изолированная система" теряет смысл; можно говорить об относительно изолированной системе.

В связи с явлением неустойчивости возникает необходимость пересмотреть такие понятия как "бесконечно малое" и "бесконечно большое". Ясно, что при небольших временах (таких, что t"1/Rel ) и Dx<<1, то есть отклонения малы, и возмущением можно пренебречь. При этом динамическим расчетам можно доверять даже в случае их неустойчивости. Время t"1/Rel называется интервалом предсказуемости (или горизонтом прогнозирования).

Ясно также, что при больших временах (таких, что Rel·t =100 - 1000) отклонение

Dx(t) станет большим при любых реальных возмущениях Действительно, для

того, чтобы пренебречь возмущениями в этом случае необходимо изолировать

систему с точностью до , что невозможно.

Здесь не обсуждалось, какую размерность имеют величины Dx(t) и Dx0 и в

каких единицах они измерены. В данном случае это и не важно. Дело в том,

что любые физические величины (длины, массы, временные интервалы, числа

частиц и т. д.) в нашем мире ограничены, то есть выражаются числами в

интервале от 10-100 до 10+100 . Большие (или меньшие) числа могут появиться

лишь как результат расчета, в котором фигурирует экспоненциальная (или

более мощная ) функция. В связи с этим Эдваром Каснером было введено новое

понятие "гугол" - столь большое число (больше 10+100 ), которое

не может соответствовать никакой физической величине (см. [10])

Возмущение является физической величиной. Отсюда следует, что начальное

отклонение не может быть меньше 10-100 , в то время как величина Rel·t

вполне может стать больше 100. Обратный "гугол" , хотя формально

является конечной величиной, реально должна рассматриваться как бесконечно

малая. В частности, вопрос: как ведет себя функция внутри интервала порядка

обратный гугол, лишен смысла. Функцию на таком интервале следует заменить

числом (средним по интервалу), поскольку более детальное её поведение

принципиально не наблюдаемо. Это утверждение. хотя и негативно, играет

важную практическую роль. что мы продемонстрируем позже.

Требует ревизии и понятие "причины" [11,12]. Обычно под причиной

понимают начальные условия (или импульсные внешние воздействия), которые

в соответствии с динамикой системы приводят к определенному результату,

т.е. - следствию. На этом языке слово "вскрыть причинно-следственные

связи" означают "понять динамику промежуточных процессов".

При этом негласно предполагают, что причины и следствия соизмеримы. Для

устойчивых (или нейтральных) процессов это всегда имеет место. В неустойчивых

процессах ситуация иная: очень малая величина приводит к следствию, которое

по масштабам с причиной не соизмеримо. Обычно в таких случаях говорят,

что причиной явилась неустойчивость, а не малое начальное воздействие.

При этом, однако, происходит весьма существенный сдвиг понятий: в качестве

причины фигурирует внутреннее свойство системы, а не внешнее воздействие.

Поясним сказанное на житейском примере. Рассмотрим два случая. В первом

хрустальная ваза стоит на середине стола (состояние устойчиво). Прошел

некто и неловким движением столкнул вазу со стола - она разбилась. В чем

причина столь печального события, или, другими словами, кто виноват? Ясно,

что виноват "некто" а причина - его неловкое движение.

Рассмотрим другой случай: ваза стоит на краю стола так, что чуть не падает

(состояние, близкое к неустойчивому). Пролетела муха - ваза разбилась.

В этом случае муху не обвиняют, а говорят, что причина события в неустойчивом

положении вазы. Виноват тот, кто ее поставил (так, чтобы никто не был

виноват, в жизни обычно не бывает). Забегая несколько вперед, отметим,

что в основе утверждения "событие произошло случайно" (то есть

без видимой причины) также лежит неустойчивость динамических процессов.

В общем случае выход из неустойчивого состояния возможен в разные стороны.

Так, шарик, движущийся по водоразделу, может свалиться как вправо, так

и влево. Направление зависит от начального возмущения.

В отсутствии выделенного направления принимается, что малые возмущения

равновероятны. Здесь мы впервые употребляем слово "вероятность".

В устойчивых динамических системах оно не употребляется и, более того,

не имеет смысла. В неустойчивых системах, напротив, достоверные предсказания

не имеют смысла, и можно говорить лишь о вероятности того или иного результата.

Таким образом, неустойчивость является тем свойством, которое позволяет

ввести в динамическую теорию понятие "вероятность".

Из изложенного следует, что устойчивость (неустойчивость) - не просто

одно из свойств динамической системы. Это свойство существенно расширяет

и изменяет аксиоматику динамических систем и позволяет взглянуть на мир

с иной точки зрения. Ярким следствием неустойчивости является "динамический

хаос".

Вернемся к системе уравнений (2.1).

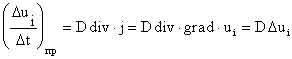

При исследовании открытых систем, способных к самоорганизации, в качестве динамических переменных ui выступают самые различные величины: потенциалы и токи в физике, концентрации различных веществ в химии, численности организмов разных видов в биологии и экологии. Число переменных в реальных системах достаточно велико. Исследовать свойства многомерных систем сложно.

На помощь приходят методы редукции, т. е. сведения системы уравнений,

содержащих большое число дифференциальных уравнений (и, следовательно,

переменных) к более простой системе из меньшего числа уравнений. Редуцированную

систему уравнений называют базовой. От неё требуется:

Во-первых, чтобы она описывала основные черты рассматриваемого явления.

Во- вторых, чтобы она содержала минимальное число переменных и параметров.

В-третьих, чтобы она была "грубой" в смысле Андронова. Последнее

означает, что при малом изменении параметров и слабом расширении базовой

системы (то есть добавлении высших производных и/или новых членов с малыми

коэфициентами), решения должны меняться мало.

В химической кинетике редукция кинетических уравнений использовалась давно

и известна как метод стационарных концентраций. Он основан на временной

иерархии процессов. Последнее означает, что характерные времена ti в (2.1)

существенно различны и их можно разделить на три группы. К первой относятся

процессы, времена которых совпадают с характерными временами интересующего

нас явления. Ко второй относятся медленные (по сравнению с первыми) процессы

и к третьей - быстрые.

Например, если нас интересуют изменения системы, происходящие за 1-10

минут, то процессы, протекающие за секунды и доли секунд считаются быстрыми,

а процессы, для которых требуются часы и сутки - медленными. Иная градация

возникает, если нас интересуют секундные изменения; тогда минутные процессы

мы уже отнесем к медленным.

Разбив реакции на такие группы, мы можем заметить следующее:

- Все медленно и очень медленно изменяющиеся концентрации мы просто можем считать постоянными и равными их начальным значениям.

- В быстрых и очень быстрых реакциях успевают установиться стационарные концентрации.

Другими словами, между соответствующими концентрациями быстро

установятся определенные соотношения и при изменении одной из них другие

почти мгновенно к ней подстроятся. В этом случае часть дифференциальных

уравнений можно заменить алгебраическими соотношениями и система упростится.

В результате останутся лишь процессы, имеющие примерно одинаковые скорости;

их, как правило, не много. Замену дифференциальных уравнений алгебраическими

называют иногда принципом стационарных концентраций.

Строгое математическое обоснование такой процедуры было дано А.Н.Тихоновым

[13] . Мы не будем здесь приводить доказательство этой теоремы, ограничимся

лишь примером.

Пусть среди n компонентов процесса имеется такой (концентрацию его обозначим

u1), который очень быстро образуется, но очень быстро расходуется. Тогда

уравнение для него можно записать в виде:

| где А = 1/ t1 >>1 | (2.6) |

Учитывая, что за времена порядка t1 все концентрации, кроме u1, изменяются слабо и считая их постоянными, можно найти стационарную концентрацию `u1 из условия:

|

|

(2.7)

|

Используя (2.7) можно выразить `u1 через другие переменные и таким образом

сократить число дифференциальных уравнений.

На первый взгляд это может показаться парадоксальным. Действительно, приравнивая

нулю функцию F(ui,) мы как бы считаем, что скорость изменения u1 равна

нулю, хотя с другой стороны именно она пропорциональна большой величина

А.

Не трудно убедиться, однако, что парадокса тут нет, если стационарное

состояние уравнения (2.6) устойчиво. Последнее является необходимым условием

теоремы Тихонова, если оно не соблюдается, то использовать метод стационарных

концентраций нельзя.

Для демонстрации этого рассмотрим решение уравнения (2.6), в случае малых

отклонений u1 от стационарного значения. В данном случае выражение (2.3)

принимает вид:

|

|

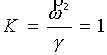

где ;

|

|

(2.8)

|

Устойчивость решения уравнения (2.6) означает, что частная производная

в (2.8) отрицательна. Число Ляпунова при этом тоже отрицательно и очень

велико (поскольку А>>1). Это обстоятельство обеспечивает быстрое

установление стационарного значения концентрации u1 , что и является основным

утверждением теоремы Тихонова.

При моделировании конкретных сложных систем (например, экологических)

сначала исследуют базовую модель и затем её расширяют до полной, которая

называется имитационной. Последняя дает те же результаты, что и базовая,

но кроме того позволяет описать поведение "деталей", то есть

тех быстрых переменных, которые в базовой модели не фигурируют.

Во многих и очень важных случаях базовая модель содержит всего два уравнения.

Для исследования их используется наглядный метод построения так называемого

фазового портрета.

Поясним его смысл на примере двух уравнений для переменных x и y.

|

|

|

(2.9)

|

P(x,y) и Q(x,y) известные и в общем случае нелинейные функции своих переменных.

На рисунке 2.1 приведена плоскость (x,y). Каждая точка на этой плоскости

дает информацию о состоянии системы (2.9) и потому называется изображающей

точкой.

Пусть в начальный момент t=0 переменные x и y равны x=x1 ; y=y1 . Вычислим

их приращения за малый интервал времени Dt. Эти приращения отложены на

рисунке (2.1). Там же приведен вектор смещения изображающей точки. Аналогично

можно вычислить смещение в следующий интервал времени. Повторяя процедуру

можно получить ломаную линию, которая при Dt®0 переходит в плавную кривую,

именуемую траекторией системы. Движение изображающей точки по траектории

дает представление о развитии процесса во времени, даже если точное решение

системы (2.9) не известно или не может быть выражено в аналитической форме.

Именно в этом заключается ценность фазового портрета.

Для упрощения расчетов удобно провести две линии P(x,y)=0 и Q(x,y)=0. На первой приращение Dx=0, то есть траектории на ней вертикальны. На второй приращения Dy =0, то есть траектории на ней горизонтальны. Эти линии называются главными изоклинами. Точки их пересечения соответствуют стационарны состояниям, поскольку при этом оба приращения равны нулю.

На этом примере удобно проиллюстрировать теорему Тихонова и прояснить

некоторые математические тонкости. Последние заключаются в следующем:

i) Полная система уравнений содержит n переменных и требует задания стольких

же начальных условий. В редуцированной системе число переменных и начальных

условий меньше, то есть часть условий оказываются лишними.

ii) При редукции нарушаются аналитические свойства решения полной системы.

Поясним это на примере редукции системы (2.9) в случае когда tx >>

ty . Cогласно теореме Тихонова систему (2.9) можно редуцировать до одного

уравнения:

|

|

(2. 10) |

где зависимость y(x) - решение алгебраического уравнения Q(x,y) =0.

На рисунке 2.1, б приведен фазовый портрет системы (2.9) при tx >>

ty. Видно, что траектории во всех точках, кроме лежащих на изоклине горизонталей,

практически вертикальны, поскольку Dy >> Dx. Поэтому изображающая

точка очень быстро, за время ty, попадает на изоклину горизонталей и затем

медленно движется к стационарному состоянию согласно (2.10). Формально

траектория плавная, но на ней имеется очень крутой поворот в точке(x1

, y2). Уравнение (2.10) этот крутой поворот не описывает, с чем и связано

нарушение аналитических свойств решения полной системы (2.9).

Начальное значение переменной y1 в уравнении (2.10) не фигурирует, важно

лишь значение x1 . Любое другое значение y, лежащее на вертикали x=x1

приводит к тому же результату. Иными словами, редуцированная система забывает

о начальном значении y.

Таким образом редуцированная система правильно описывает процесс на

ограниченном, но наиболее важном для данной задачи, временном интервале.

Информационные аспекты редукции (и теоремы Тихонова) в следующем. При

редукции сложной системы количество информации сокращается, сохраняется

только ценная информация, а не ценная забывается.

Мы остановились на этом примере столь детально, поскольку редукция сложных

систем играет очень важную роль при описании и исследовании процессов

самоорганизации.

Как упоминалось, редукция основана на временной иерархии. Возникает вопрос:

в каких случаях она имеет место и почему. В неживой природе она имеет

место далеко не всегда. Так, например, при горении водорода образуется

много промежуточных продуктов и времена их взаимопревращений примерно

одного порядка. В процессах самоорганизации в живой природе, напротив,

временная организация наблюдается практически всегда. Тому есть причины.

Дело в том, что задачи моделирования и самоуправления во многом сходны

и временная иерархия необходима и для того и для другого.

Отсюда следует на первый взгляд парадоксальный вывод: построение математических

моделей живых самоорганизующихся систем - задача более простая, чем моделирование

процессов в неживой природе, хотя и последнее интересно и важно. Возможно,

именно с этим связаны успехи синергетики в биологии, экологии и социальных

науках.

Стационарные состояния динамической системы могут быть разного типа. Их

классификацию удобно привести на примере системы (2.9),

- Устойчивый узел - так называется стационарное состояние в случае, если траектории упираются в точку, то есть приближаются к ней апериодически. При этом в линейном приближении вблизи точки все числа Ляпунова вещественны и отрицательны.

- Устойчивый фокус - в этом случае траектории имеют вид свертывающихся спиралей и изображающая точка приближается к стационару, совершая затухающие колебания. При этом числа Ляпунова комплексны; реальная часть их отрицательна, а мнимая равна частоте колебаний.

- Центр - в этом случае траектория представляет собой замкнутые кривые.

Числа Ляпунова при этом чисто мнимые. В системе происходят незатухающие

колебания амплитуда которых зависит от начальных условий (но не от параметров